はじめに

先週、AWS Trainiumの実物、ということでブログを書きましたが、推論チップの Inferentia2 が Trainium とほぼ同じような構成でした。

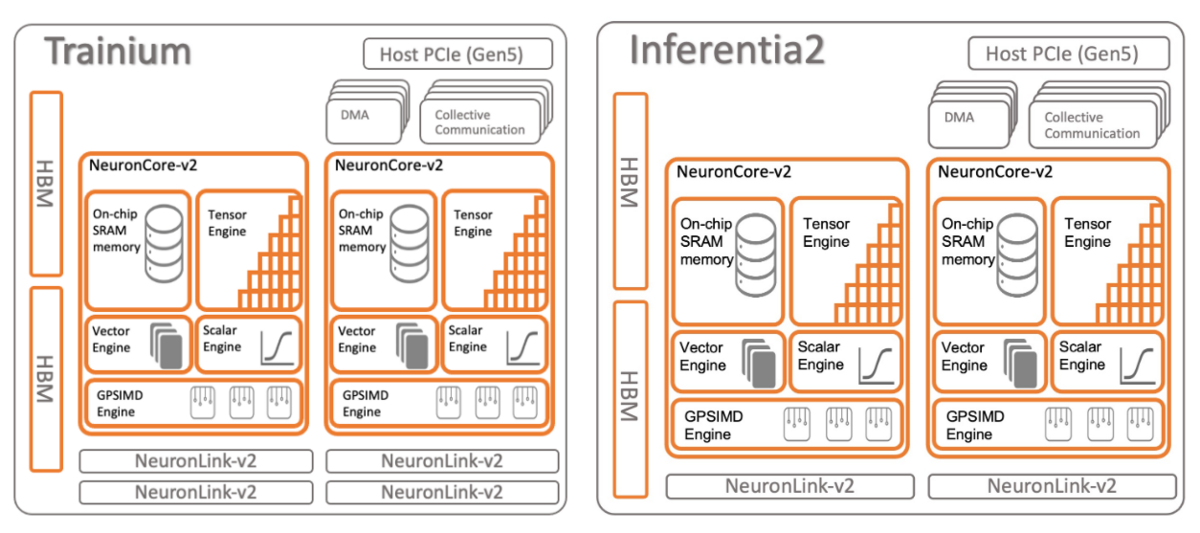

上記のサイトからそれぞれの絵を説明のために引用します。違いは、NeuronLink-v2の本数だけっぽいです。

Inference2

低コストで高性能な生成系 AI 推論用の Amazon EC2 Inf2 インスタンスが一般公開されました

を読んでみたら、推論でもマルチチップ構成になるLLM対応のためっぽいですね。

Inferentia2 x 6、x12構成がとれて、NeronLink-v2 で接続されています。

おわりに

AWSのInference2って、Trainium をそのままつかっているのではないでしょうか?

と、思っています。