はじめに

Microsoft が Maia 100 を発表し、来年にサービスインすることで、3大 Cloud Service

にて、AIアクセラレータを利用できるようになります。

今回は、既にサービスを行っている

について、振り返りたいと思います。

Google TPU v5e

Google TPU v5e の性能は、

- BF16 : 197 TFLOPS

- INT8 : 343 TFLOPS

pricing は、$1.20/hour です。

AWS Trainium/Inferentia2

Trainium および Inferentia2 の性能は、

- FP8/FP16/BF16/TF32 : 190 TFLOPS

です

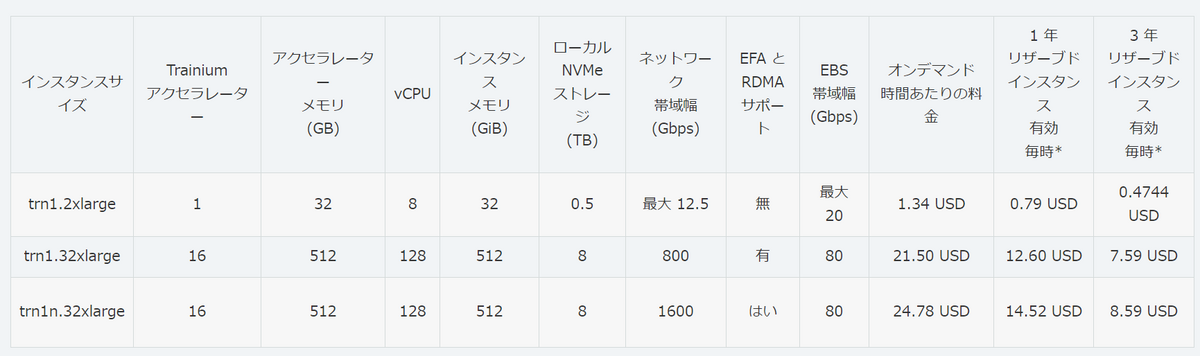

pricing は、下記のように、

- trn1.32xlarg : $21.50 (Trainium x 16)、$1.34375

- inf2.24xlarge : $6.49 (Inferentia2 x 6)、$1.0817

- inf2.x24xlarge : $12.98 (Inferentia2 x 12)、$1.0817

です。

比較

TPU v5e と Trainium/ の BF16 はほぼ同じなので、

で比較すると、

- $21.5 vs $19.2

で、ほぼ同じです。

TPU v5e の INT8 が 383 TFLOPS、Inferentia2 の FP8 が 190 TFLOPS なので、

で比較すると、

- $12.98 vs $7.2

で、TPU v5e の方がお安いです。

FP16で比較すると、

になるので、

- $12.98 vs $14.4

になり、ちょっとだけ、AWS Inferentia2 の方がお安いです。

おわりに

AWS trn1.32xlarge の性能は、190 T x 16 = 3040 TFLOPS == 3 PFLOPS です。これが、$21.5 です。

AWS Trainium2 は、Trainium の4倍ということで、ノードは 8個のTrainium2になりそうなので、2倍になり、6 PFLOPS です。これが2倍の $43 になることはなさそうです。1.5倍程度と考えると、6 PFLOPS を $30 ぐらいだとお安いということになるんでしょうかね。

Trainiumの時は、FP8 と FP16/BF16 が同じ 190 TFLOPS だったので、Trainium2 はもしかしたら、FP8 を2倍にして、NeuronCoreの数は2個のままかもしれません。

となると、BF16/FP16 は同じで、FP8が2倍になっているというのかもしれません。

つまり、Trainium2 は、v5e 対抗であり、推論時でも Google TPU v5e と同等にできるということになるのでしょうか。。。

MicrosoftのMaia 100がどのぐらいのprining になるかというと、

- 3 PFLOPS では、$20以下は must

- 6 PFLOPS では、$30台

ということではないでしょうか?

AWS の H100のノード(p5.48xlarge)、H100 x 8 (640GB)で、$98.32 です。H100は、1 POps(BF16/FP16) なので 3 POpsだと、3/8 x $98.32 = $36.87 です。

ベンチマークは、$20以下で、H100ベースだと、$36.87です。

36.87/20 = 1.8435 なので、1.8倍の性能であれば、OKですね。。。