はじめに

NVIDIA GH200の ZeRO-Inference のベンチマーク値が出てきたので見てみます。

ZeRO- Inference とは、

GH200 vs H100-80GB vs A100-80GB

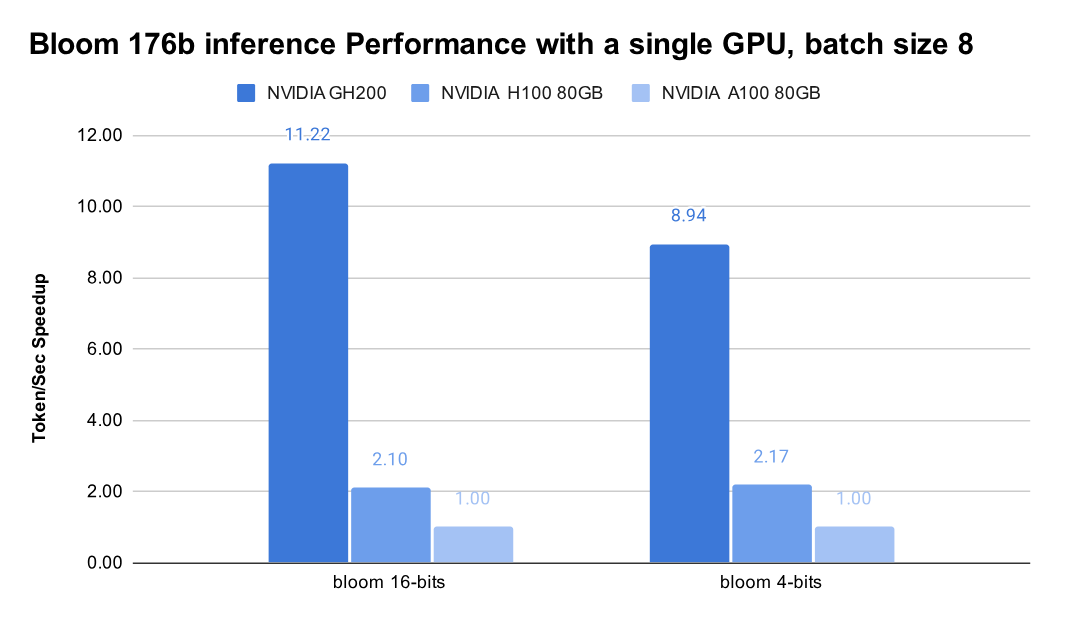

下図は上記の記事から説明のために引用します。

Bloom 126b inference Performance with a single GPU, batch size 8 でのベンチマークのようです。A100-80GB を基準として、

- bloom 16-bits

- GH200 : 11.22 倍

- H100 : 2.1 倍

- bloom 4-bits

- GH100 : 8.94 倍

- H100 : 2.17 倍

のようです。

Bloom 176b ということは、16ビットで換算すると最低 352GB必要です。4ビットでは 88GB 必要です。となると、A100/H100の80GBではGPUのメモリでは足りないです。また、GH200も94GBなので足りないです。そうなると、CPU側のメモリにアクセスする必要がありますね。

A100 => H100 では、2倍程度。A100 の BF16が312 TFLOPS に対して、H100の 989 TFLOPS なので3倍になってもおかしくないのですが、メモリアクセスがボトルネックになっている感じですね。。。

おわりに

GH200、A100-80GB/H100-80GBに比べて、これだけ性能がいいのなら、Inference として利用されるかもしれませんね。。。