ここかは、NNP-Lと出てきます。

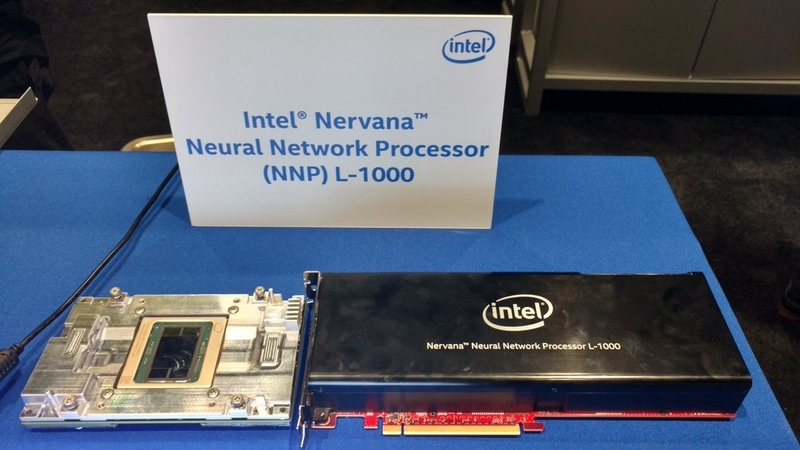

NNP L-1000 for Deep Learning Training ・OCP Accelerator Mezzanine Module ・Standard PCIe Module ・Leveraga both on-die SRAM and on-package => 写真を見ると、HBM が4個載っています。 ・Bfloat16 for enhanced performance and convergence ・Massive bi-directional data transfer through on an off chip interconnect

とありますね。

展示もしているようで、

PCIe Module の裏面、がっしりしているのに、OCP Module はそうではないのは何か違うのでしょうか?

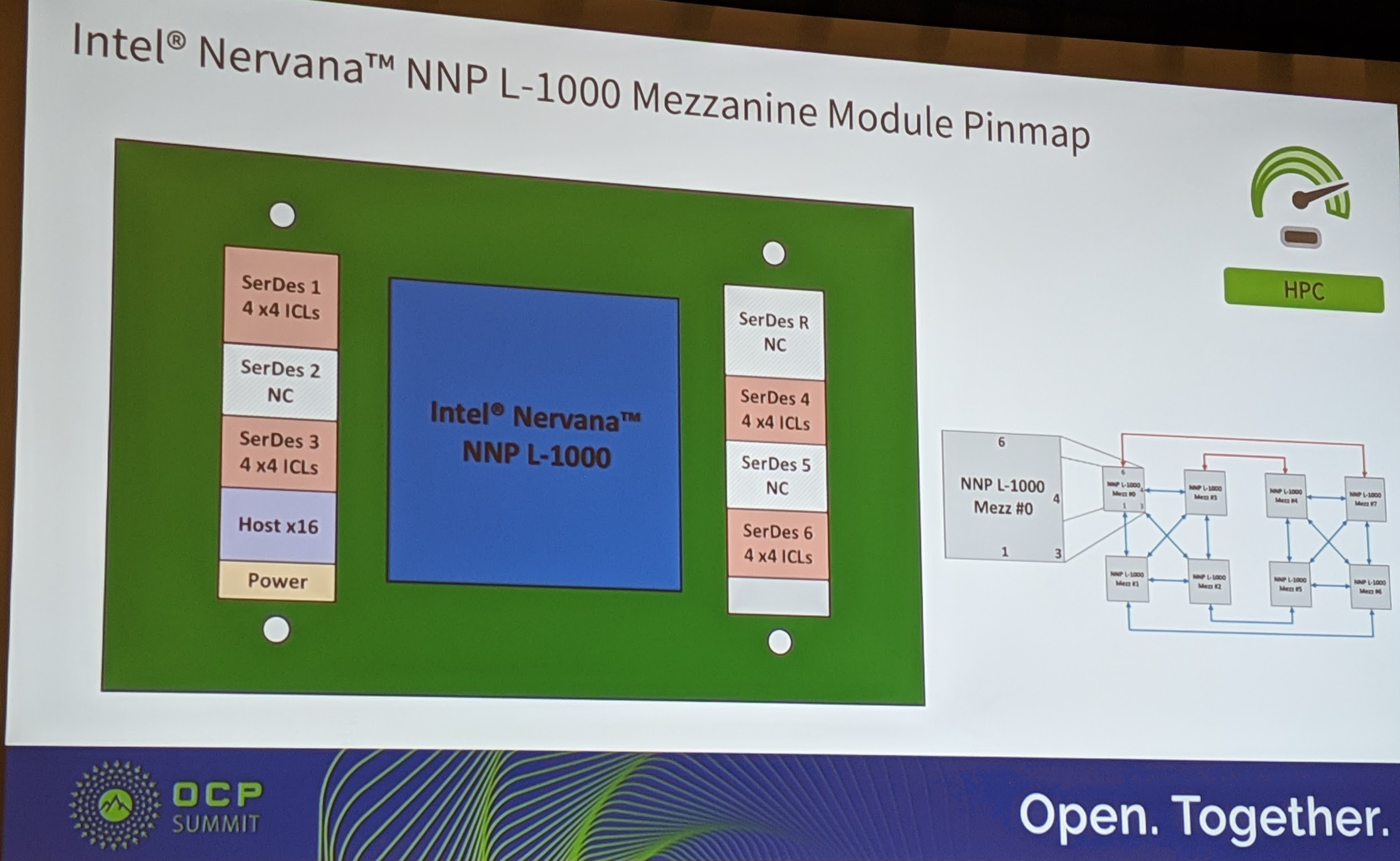

この写真には、NNP-Lの接続図が載っていて、SerDes 4x4 ICLs が 4組 と Host x16があります。1つの NNP-L は、4つの NNP-L と接続するのですね。

SerDes 4x4で4つのNNP-Lと接続できると、

NVIDIAのV100のNVLinkは6組ですが、4つのV100と接続しているので、基本的には同じようですね。

なので、NVIDIAもOCPモジュール提供して、8個載せられるのでしょうかね。

NVIDIAのV100のNVLinkは6組ですが、4つのV100と接続しているので、基本的には同じようですね。

なので、NVIDIAもOCPモジュール提供して、8個載せられるのでしょうかね。

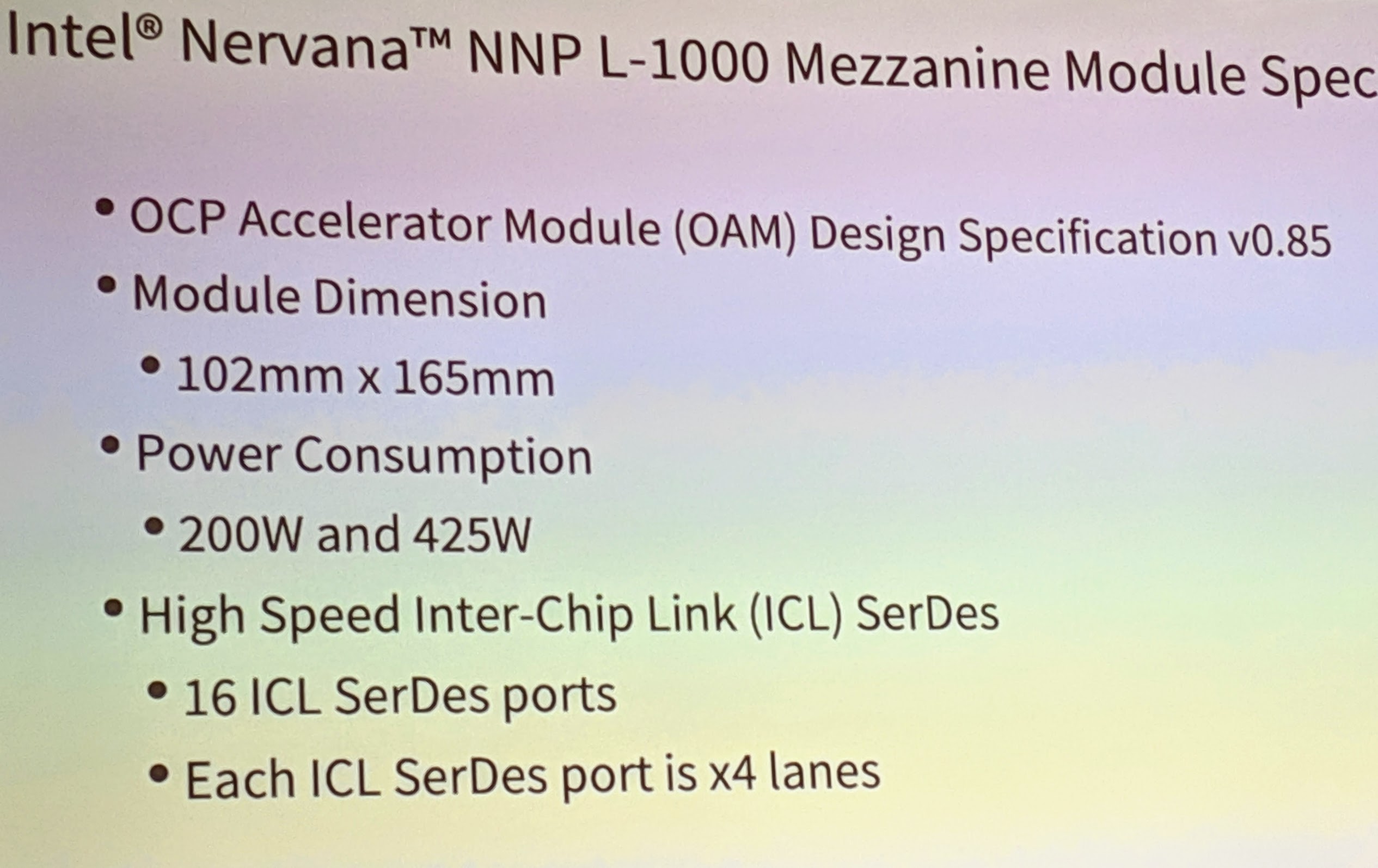

この写真によると、消費電力は200Wと425W のようです。

そして、ここからは、NNP-Iが出てきます。

NNP I-1000 for Deep Learning Inference ・Deep Learning by Design ・Intel 10nm Ice Lake Core ・In Production in 2019

こちらは、M.2 module で外部にメモリが無いですね。裏面に載っているのでしょうか?

これら2つのチップは、Intel nGraph によって、利用可能になるようです。