はじめに

Ampere Computing の Altera Max ベースの NVIDIA A100 サーバーの情報が出てきました。

Gigabyte's G492-PD0 server

Gigabyteのサイトは、こちら

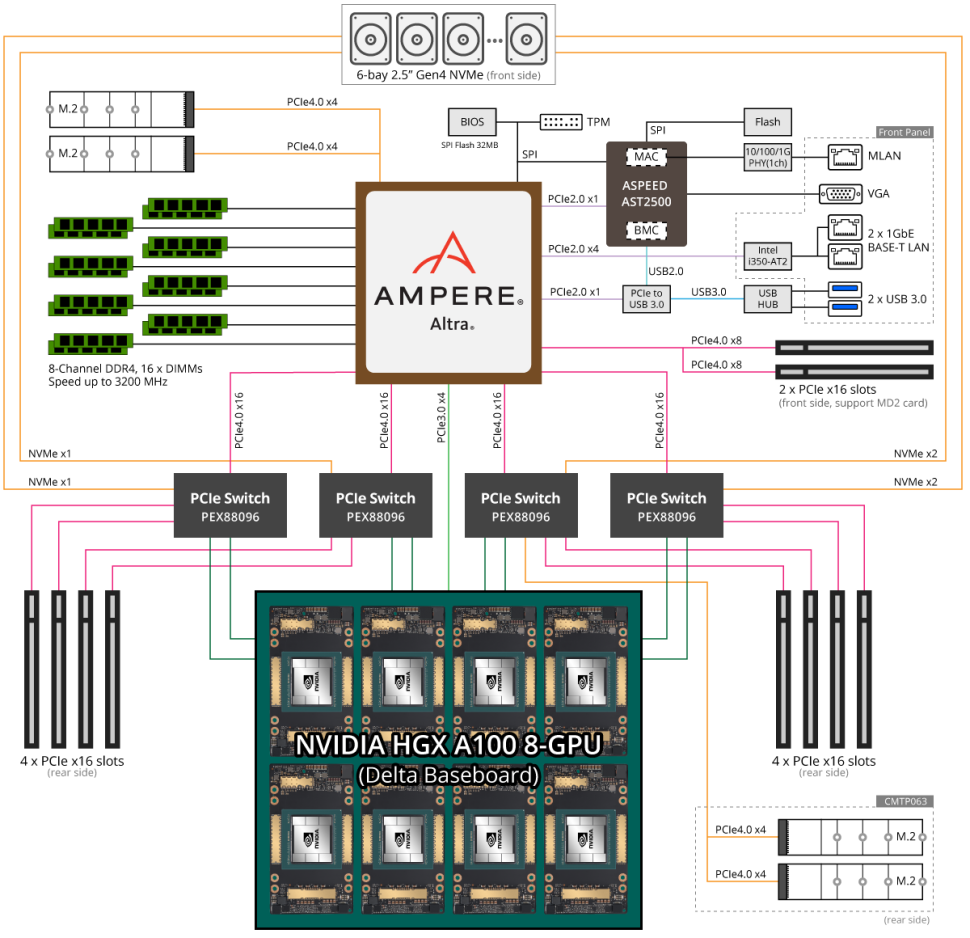

説明のために下図を引用します。

GPU側とは、Ampere Altraの PCIe (Gen4 x16) x 4組 + PCIe Gen 1 x4 と接続しています。x16 は PCIe Switch に接続していて、そのPCIe Switch には、

- A100 x 2

- PCIe Gen4 x16 x 2 (Network Card)

- NVMe x 1 or 2 (左側の2個は、x1、右側の2個は、x2)

が接続しています。DGX A100 では、NVMe は1個ではなく、2個、各GPUに1個接続しています。

PCIe Gen3 x 4 は、NVSwitch 用のPCIe Switch に接続しているんだと思います。その PCIe Switch の先に NVSwitch x 6 が接続しているんだと思います。

Altra Max からの PCIe は、

- GPU 側へ Gen4 x 16 x 4 + Gen3 x 4 = 68

- Slots : Gen4 x 8 x 2 = 16

- M.2 : Gen4 x 4 x 4 = 16

- BMC : Gen2 x 1 = 1

- GbE : Gen2 x 4 = 4

- USB : Gen2 x 1 = 1

合計で 102 lanes

- Gen4 x 16 x 4

- Gen4/CCIX x 16 x 4

の 128 lanes かつ 32 controllers to support up to 32 x4 links。上のブロック図では、

- Gen4 x 16 x 4

- Gen4 x 8 x 2

- Gen4 x 4 x 4

- Gen3 x 4 x 1

- Gen2 x 4 x 1

- Gen2 x 1 x 2

で、14コントローラなので、OKそうですね。。。

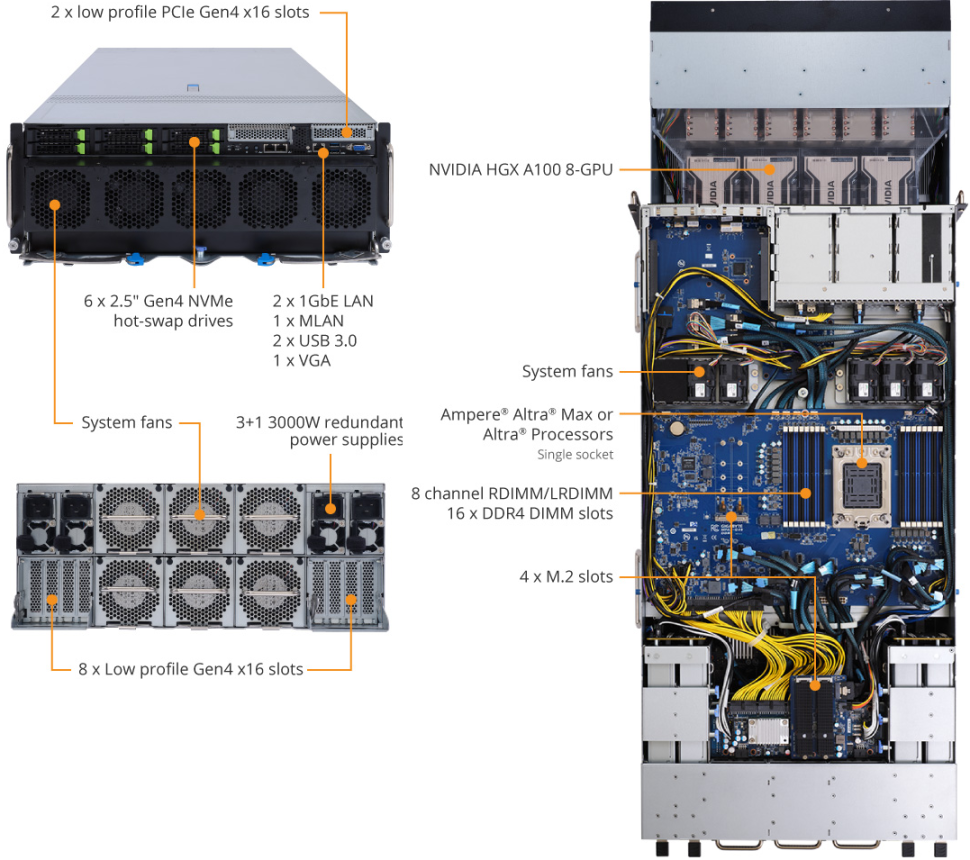

下図も説明のために引用します。下段はGPU側、上段がCPU側です。下段に x16 x8 の PCIe Slot がありますね。

右のCPU側のボードの上部に、BMC、GbE、USB、6-bay 2.5" Gen4 NVMe, Gen4 x8 x2 が繋がっていて、中央部に 4 x M.2 slots が繋がっていますね。下部のコネクタからケーブルでGPU側へ、Gen4 x 16 x 4 (PCIe Switchへ) + Gen3 x4 が繋がっているっポイです。

GPU側は 下図(説明のために引用します)NVIDIA HGX A100 8-GPU です。となると、左下がPCIe になるので、この部分にCPU側からのケーブル、PCIe Siwtch 、Network card が接続するためのボードが接続することになるんですね。となると、CPU側の上部の NVMe へのケーブルは、下部から引っ張っている感じですかね。

AMD EPYC MILAN ベースのG492-ZD0のブロック図(説明のために引用します)は、同じHGX A100 8-GPUを使っていますが、PCIe Switch (PEX88096)に接続するデバイスがちょっと違いますね。EPYCの場合は、2ソケットだからですかね。

おわりに

Ampere Computing の Altra Max ベースのサーバーの実物がやっとでてきました。