はじめに

Meta が MTIA を発表しました。

下記のツイートはMeta関連者のツイートです。

Lots of big AI news from us today: our next gen data centers designed from the ground up for AI workloads, our first custom silicon for AI training & inference, and phase two of our Research Supercluster, one of the world’s most powerful AI supercomputershttps://t.co/lUGZRtVvdK

— Boz (@boztank) 2023年5月18日

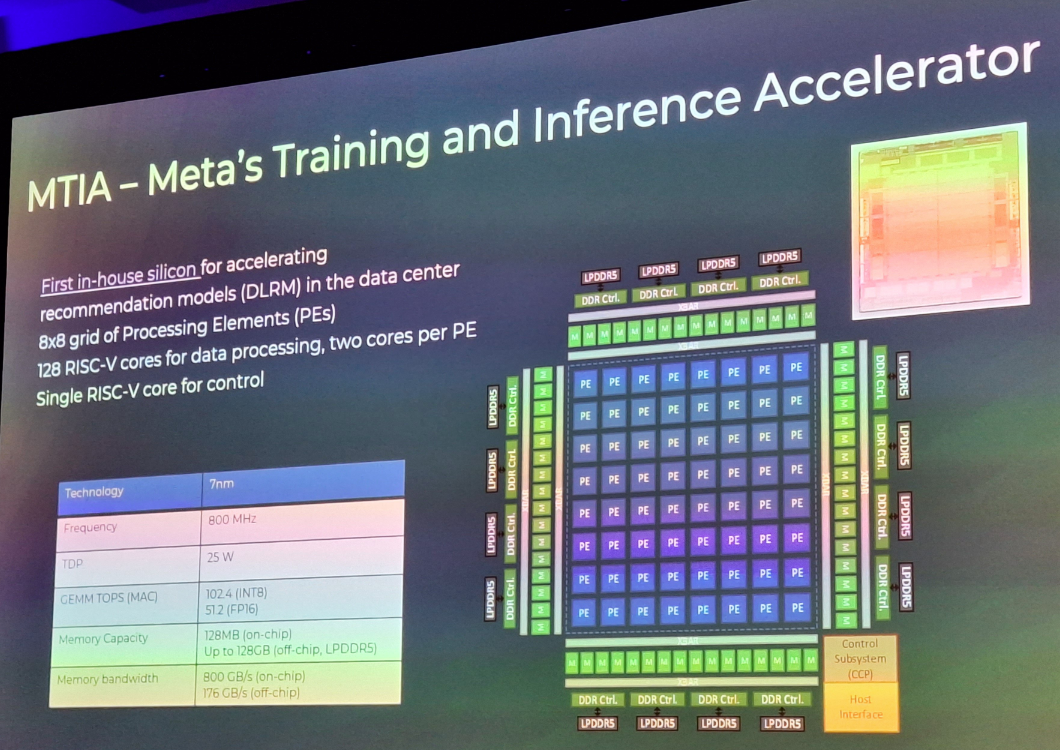

MTIA v1

MTIA : Meta Training and Inference Accelerator です。今回発表されたのは、MTIA v1 です。Package に印字されている情報から 2021年にはできていたようです。

説明のために下記の写真を上記のページから引用します。

In 2020, we designed the first-generation MTIA ASIC for Meta’s internal workloads.

TSMC 7nm

- 800 MHz

- 102.4 TOPS at INT8

- 51.2 TFLOPS at FP16

- 25 W (TDP)

- LPDDR5 : 256bit (64bit x 4 => 16bit x 4 x 4、Max : 128GB (32GB x 4)

- PE (RISC-V2種 + 128KB SRAM): 64 (8 x 8), two cores per PEなので、128 RISC-V cores

- Internal SRAM : 128MB (4MB x 8 x 4)

- PCIe Gen4 x 8

PE (Scalar RISC-V + Vector RISC-V)

おわりに

MetaがFacebookの時に、Inference用のチップとしては、Intel NNPI を使っていたようですが、MTIA v1 に変わったんでしょうかね。Intel NNPIの時は、GLOWだったんですが、MTIAはPytorch2なんですね。GLOWってメンテナンスフェーズなんでしょうかね。

ちなみに、Intel NNPIについては、このブログでも何度も取り上げています。

関連記事

追記)、2023.11.08

このツイートから

DLRMがポイントね。

下記のグラフ、大きなモデル(HC、725 B)では、NNPIでは遅い。。。MC2までなら、MTIAがNNPIより速いし、GPUより速いものもある。

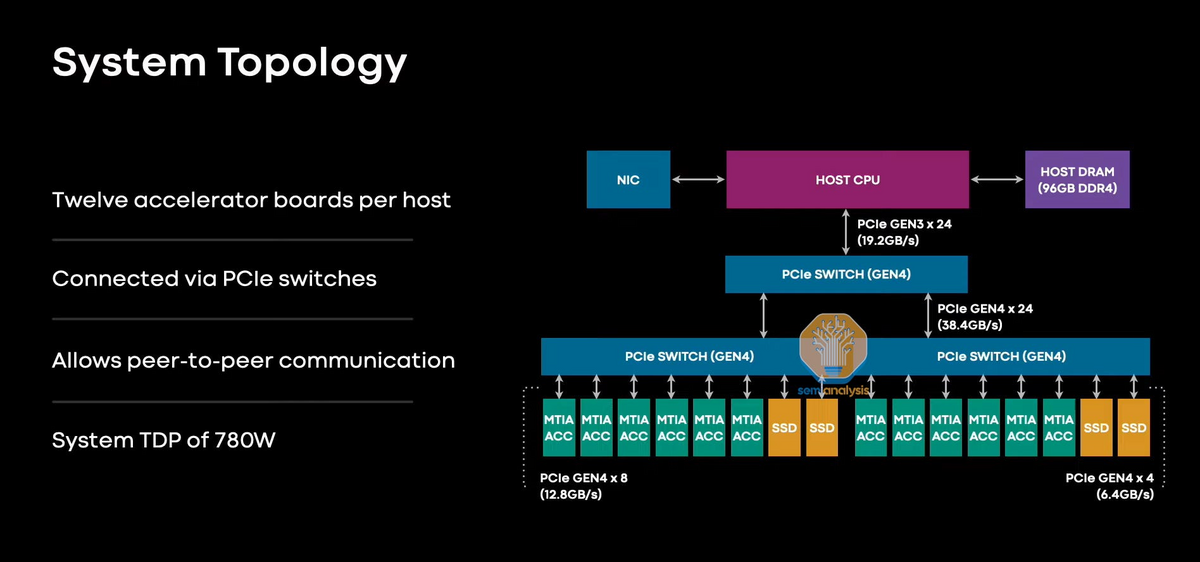

より、システム構成は下記の通り、MTIAは 6 + 6 = 12 枚ささる。