はじめに

COMPUTEX TAIPEI 2023 にて、NVIDIAが Grace-Hopper Superchip の名称を GH200 と発表。また、このGH200を最大256個搭載する DGX GH200も発表

GH200

3月のGTC2023にて、Grace-Hopper SuperchipベースのDGXを発表するのかな?と思いましたが、その時には発表されず。今回のCOMPUTEX TAIPEI 2023での発表になりました。型番は、GH200 (Grace Hopper かな?)。この型番、下記の1年前のブログで取り上げていて、GraceはTH500、GH180はGH100+TH500、GH202はclient GPUなどという型番があったとか、なかったとか。

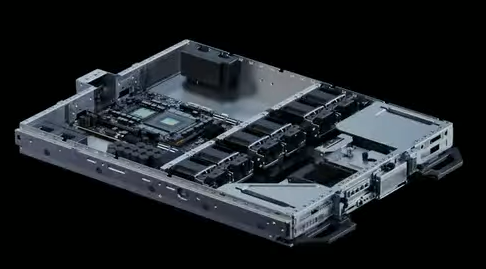

下記の写真は、このツイートからの引用です。GTC2023の時に発表された基板と微妙に違います。

DGX GH200

下記のDGX GH200の写真を、NVIDIA introduces DGX GH200 supercomputer with 256 Grace Hopper superchips から説明のために引用します。GH200のノードは、16 Rack。各 Rack に 8 x GH200 が2組あります。各 GH200 x 8 に対して、Level 1 NVLink Switchが付いています。真ん中に、18 x 2 (36) 台の Level 2 NVLink Switch があります。水色のケーブルは、GH200から出ているInfiniband用のケーブルでしょう (GH200ノードには、Bluefield-3が載っていると妄想しています)

DGX GH200 は、GH200 を 256個繋げたSupercomputer。256個なのはNVLINKの仕様で256までしか繋げられないので。

下図は上記のYoutubeにアップされたビデオからキャプチャしたもので、説明のために引用します。右側に NIC の口がありますね。こちらは、Bluefield-3なんでしょうかね。この後の説明で Bluefield-3 と言っています。

下図は、THE NEXTPLATFORM の記事 : NVIDIA’S GRACE-HOPPER HYBRID SYSTEMS BRING HUGE MEMORY TO BEAR にある図です。説明のために引用します。

- 8台のGH200を3台の NVLink Switch で束ねる

- それを 36台のNVLink Switchで接続する

感じです。その時のプレゼンテーションシーンです。このツイートから説明のために引用します。NVLink Switch の種類が違いますね。右側のNVLink Switchは、既に発表があったもので、128 NVLink4 Portsのもののようですが、左側のはちょっとちがいますね。

写真を拡大してみましょう。右側は 16 個のコネクタがあります。このコネクタは2段になっているので、全部で32個のコネクタ。2つのコネクタで 4 NVLink4 になっているので、32 x 4 = 128 NVLink4 ports ということになります。一方、左側は、こちらも 16個のコネクタがあります。

上記のTHE NEXTPLATFORMの図では、各GH200から3つのLevel 1 NVLink Switchに接続しています。GH200のGH100のNVLink4 Portは18個です。3つのLevel 1 NVLink Switchに接続するということは各NVLink Switchには6 NVLink4 Port接続することになります。

一方、既に販売している DGX H100ベースのSupercomputer である、DGX H100 SUPERPODの構成は、

- 32台のDGX H100

- 18台の NVLink Switch

になっているので、NVLink Switch の数が倍以上になっています。

下記の写真は、NVIDIAのSuperPODのページから説明のために引用します。

各DGX H100からは72 NVLink4 Portのコネクタが付いています。72 NVLink4 Port を 18個の NVLink Switch と接続するということになります。DGX H100からは、4(16) + 5(20) + 5(20) + 4(16) = 18個のコネクタで72 NVLink4 Portが出ています。つまり、各DGX H100は18個のNVLink Switchと接続していることになります。

DGX H100間の接続は結果として、4 NVLink4 Port での接続になります。NVLink4 Portの転送帯域は、双方向で50GB/s(50Gbps-PAM4 x 2 = 100Gbps x 2 = 200Gbps x 双方向 = 400Gbps = 50GB/s) です。4 NVLink4 port だと、双方向で200GB/s、つまり、800Gbps の InfiniBandやEthernetで接続していることと同じになるということですね。

下記の写真は、Youtube : Unboxing the Ultimate AI Server: Dell PowerEdge XE9680からキャプチャしたものです。

また、下記の写真は、Youtube : Dell PowerEdge XE9680: Remove/Install H100 GPU Boardからキャプチャしたものです。NVLink のコネクタが載っていない基板になります。

72 NVLink4 Port を 18 台の NVLink Switch に接続するということは、各 NVLink Switch に 4 NVLink4 Port (1つのコネクタ)になります。

DGX GH200の場合は、1ノードから 18 NVLink4 Port で3つのLevel1 NVLink Switchに接続するのですが、1つのコネクタ(ケーブル)は4 NVLink4 Portなので2個必要になります。つまり、GH200から各Level 1 NVLink Switchには2本のケーブルで繋がっている。2 x 8 = 16 個のコネクタ。Level 2 NVLink Switch は36台なので、各Level 1 NVLink Switch の残りの16 NVLink4 Port x 3 = 48 NVLink4 port を使って、36台の Level 2 NVLink Switch に接続しているんですね。

DGX GH200は、DGX H100 SUPERPODと同じように、ノード間を 4 NVLink4 port (双方向で200GB/s) で接続していることになります。

DGX H100では、4つの NVLink Switch と 8個のH100を接続していましたが、DGX GH200では8台のGH200を3つの NVLink Siwtch Box、つまり、6個のNVLink Switchで接続しています。これは、下図(この図は、Hot Chips 34でのNVIDIAの講演資料の5ページから説明のために引用します)にあるように、DGX H100からの18 NVLink4 を 4つのNVLinks Switch に、(5 + 4 + 4 + 5) NVLink4 port で接続しているのに対して、GH200では3つのNVLink Switch に 6 NVLink4 port で接続しているためです。

おわりに

今回のDGX GH200の発表で、Grace-Hopper Superchipの発表からいずれ出てくるであろうシステムが正式に発表されました。DGX H100 SUPERPODに対して、H100の数とノード間の接続の帯域は同じですが、Graceに接続されている 512GBのメモリもGPUから直接アクセスできるようになり、DGX GH200全体で 144TB のメモリが Unified memory として使えるのが大きな特徴です。

も DGX GH200 の導入を同時に発表しています。DGX GH200 は、今年の年末には利用できるようです。

次は、来年2024年に発表になる、Hopper Next、そして、再来年2025年に発表になるであろう Grace Next が注目すべきものだと思います。

さて、どのような新しい技術を導入するのでしょう!!!

関連記事

関連ツイート

Grace Hopper vs Grace CPU Superchip

— Andreas Schilling 🇺🇦 (@aschilling) 2023年6月1日

1,000 vs 500 watts pic.twitter.com/Yv9nX99g1j