はじめに

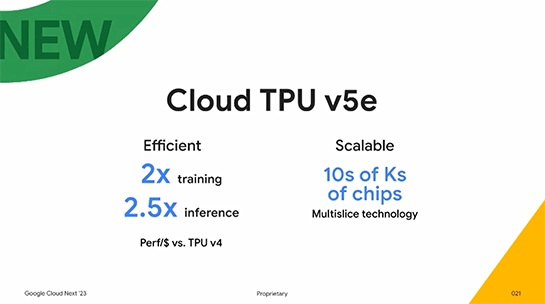

Google Cloud Next '23 にて、Google が TPU v5e を発表しました。

Efficient (Per/$ vs. TPU v4)

- 2X training

- 2.5x inference

Scalable

- 10s of Ks of chips (Multislice technology)

ほんのちょことしかなかったですが、下記のブログに詳しく書いてありました。

上記のブログの中の下記のYoutube「Inside a Google Cloud TPU Data Center」に、TPU v4 Pod と TPU v5e および v5e Board が出てきました。

v5e Board と v5e Pod

以降、写真は上記の「 Inside a Google Cloud TPU Data Center」からの引用になります。

下記の写真は、v5e Board です。とにかくデカいです。チップの上下にあるヒートシンクは電源関連のためだと思います。v5e は4か所でねじ止めされて冷やされるのだと思います。

下記は、v4 Board です。ここから説明のために引用します。

v4 Board と v5e Board の違いは、ホストに接続するポートが 4個 => 2個。Board間を接続する ICI 用のコネクタが 4個口 x 4 => 4個口 x 2 になっています。v5e Boarrd には、4個のv5eが載っているので 2個のホストと接続するコネクタは上の方の2つのChipに接続しているんじゃないかと思っています。これは、PCIe Gen5 x8 Switchで2つの v5e と接続しているのでは?と

下図は、v5e Pod の写真です。こちらは、ブログ(Expanding our AI-optimized infrastructure portfolio: Introducing Cloud TPU v5e and announcing A3 GA)から引用します。v5e Pod は 256 CHipで構成しているようなので、左下の4つのRack (1 Rack に 16 Board x 4 Rack)で、4 x 16 x 4 = 256 chips

下記の写真は、v5e chip の拡大したものです。HBMが2個載っています。v4 では 4個のHBM2 が載っていました。HBMの大きさがかなり大きくなったので、HBM2ではなく、HBM3を使っているのでは?と思っています。

ちなみに、TPU v2/v3/v4 はすべて HBM2 (HBM2eではない)です。HBM2 の最大周波数は 2.4Gbpsです。HBM3は 6.4Gbps なので 2.5倍です。メモリを4個から2個にしても帯域的には問題なさそうです。

また、HBM2 は 8 CH (16 P-CH) 対して、HBM3 は 16 CH (32 P-CH)になり、CH数が倍になった(データ幅は半分)のも関係しているのかもしれませんね。

追記)

どうやら、HBM2e@3.2Gbps のようです。

新しい v4 Pod ?

の最後にある v4 Pod の写真を引用します。

今回公開されたビデオでは、ホストの高さが違いますね。高くなっている気がします。

おわりに

今回、発表があったのは、v5e です。 e が付いています。これは、何を意味するのでしょうか?

また、詳細はいつ公開されるのでしょかね。