はじめに

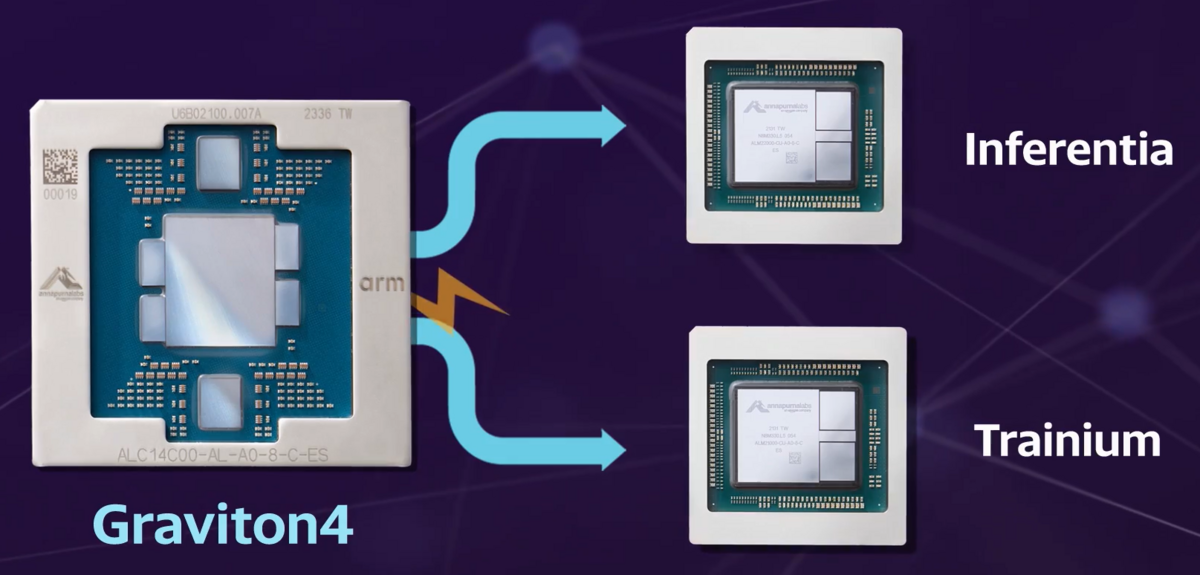

Xの下記の投稿によると、AWSがGraviton 4を Trainium/Inferentiaと接続して使うと。

Amazon AWS showed off Graviton4, its 4th-generation general purpose processor with 3x the compute power and memory than its predecessor, and 75% more memory bandwidth and 30% better performance, Yahoo News reports, adding the processors are rented out for $0.02845 per second of…

— Dan Nystedt (@dnystedt) 2024年7月10日

元ネタ

元ネタは、米国Yahoo Finance の下記の記事です。

この記事の中のビデオです。下記のようなものが流れてきます。説明のために引用します。

上記では、Inferentia となっていますが、本当は Inferentia 2 だと思います。 Inferentia 2 と Trainium は実態は同じです。

これは、

- 推論用の Inferentia シリーズ

- 学習用の Trainium シリーズ

の CPU として、Intel/AMD の x86_64 ではなく、AWSの Graviton 4 を使うということです。

Trn1/Trn1n Architectureのアーキテクチャによると、

- Trn1.32xlarge

- Trn1n.32xlarge

共に、vCPU は 128 です。 Graviton 3 の CPU は、64です。

一方、AWS Inf2 Architectureによると、

- Inf2.24xlarge は、96 vCPU

- Inf2.48xlarge は、192 vCPU

です。Inf2.48xlarge が 1ノードと認識しているので、Graviton 3E 搭載のAmazon EC2 C7gnを見てみると、3個載っているので、192 vCPU でOK そうです。

おわりに

Trainium / Inferentia 2 で既に、Gravition 3E との接続をしていたっポイですね。

Graviton 4 と Trainium 2 になると、となると、

- NVIDIA : Grace + Hopper (GH200) => Grace Blackwell (GB200)

- AMD : MI300A => MI400A ?

- AWS : Graviton 3E + Trainium / Inferentia 2 => Graviton 4 + Trainium 2 / Inferentia 3

- Intel : Xeon + Gaudi 2 => Xeon Gaudi 3 => Falcon Shores

のように、CPU + AI アクセラレータが自社で作れないとかなり辛くなるのでは?と思います。

今から2年前の2022年6月26日の下記の記事に書きましたが、

2021-12-01の下記の記事では、既にAWSもやっていたんですね。ただし、同じパッケージではないけど。

AWS は、CPU と AIアクセラレータは、PCIe GenX x16 で接続しています。もしかしたら、この部分を独自にしていくかもしれません。

AWS は、UALink には参加していないので。。。