はじめに

昨日の続き。

発表があった Rubin と Rubin Ultra の違いを妄想します。

Let's 妄想

Rubin と Rubin Ultra

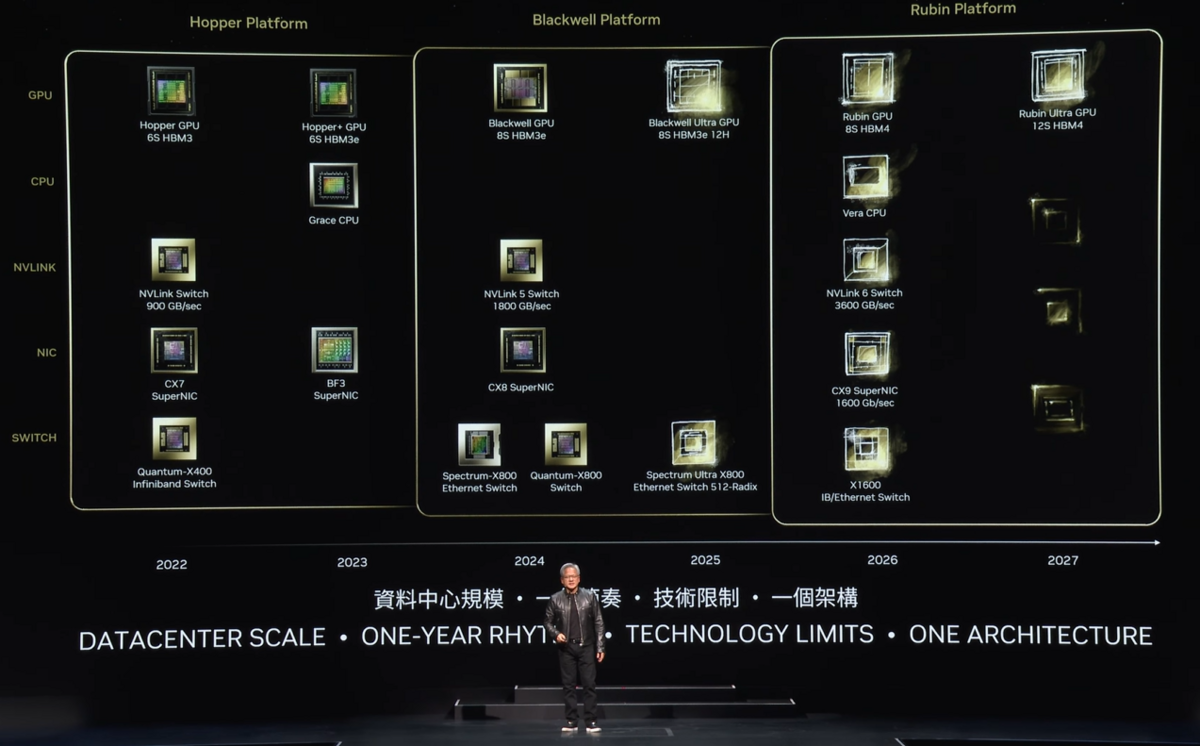

下図は、上記のYoutubeから説明のために引用します。

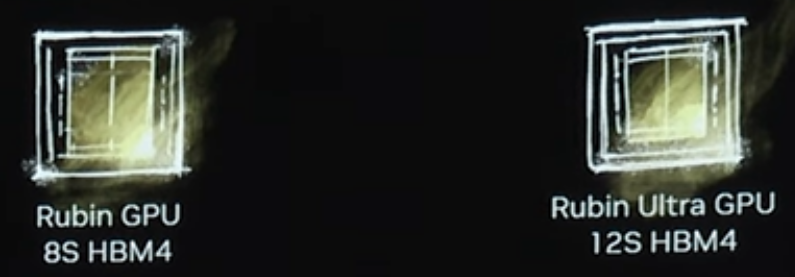

Rubin と Rubin Ultra の部分を拡大したのが下図。

Blackwell と Blackwell Ultra では、HBM3eの数は8個で同じでしたが、Rubin が 8個に対して、Rubin Ultra が 12個になっています。

一瞬、作り直すの?と思いましたが、

- Rubin : 2 x Compute Die + 8 x HBM4

- Rubin Ultra : 3 x Compute Die + 12 x HBM4

になれば、OK だということに気が付きました。

Blackwell Platform では、2 Die を対向で接続すればいいのですが、Rubin Platform では、Compute Die と I/O Die から構成され、Rubin では 2 x Compute Die + 2 x I/O Die + 8 x HBM4 で、Rubin Ultra では 3 x Compute Die + 2 I/O Die + 12 x HBM4 になるのでは?と思います。

これが合っていれば、

- Rubin => Rubin Ultra

の性能およびメモリ容量は、1.5倍になるということです。ただし、消費電力を考慮すると、1.5倍にはならないかもしれません。

Package

Package に関しては、下記のブログにも書いたように、CoWoS-S ではなく、CoWoS-L になると思います。

このブログでは、Q4.2025 に Rubin となっていましたが、HBM4のスケジュールを考えると、2026 では?と疑問が残っていました。

今回のNVIDIAの発表では、Rubin は 2026 になったので、その疑問も消えました。

Rubin、Rubin Ultra 共に、CoWoS-L になるんでしょうね。。。

I/O Die

Rubin は、

- NVLink v6 : 3600GB/s

となっています。PCIe は、

- Gen6 x16

だと思います。

となると、1つの I/O Die に、1800GB/s の NVLink v6 と PCIe Gen6 x16 が載る必要があります。

NVLink v4 (Hoppr) は、

- 100Gbps-PAM4 x 2 = 200Gbps x 18組 = 25GB/s x 18組 = 450GB/s (片側)

になっています。

NVLink v5 (Blackwell) は、

- 100Gbps-PAM4 x 4 = 400Gbps x 18組 = 50GB/s x 18組 = 900GB/s (片側)

- 200Gbps-PAM4 x 2 = 400Gbps x 18組 = 50GB/s x 18組 = 900GB/s (片側)

のどちらかではないでしょうか? 200Gbps-PAM4 は、既にありそうなので、2) になりそうです。

NVLink v6 (Rubin) は、

- 200Gbps-PAM4 x 4 = 800Gbps x 18組 = 100GB/s x 18組 = 1800GB/s (片側)

- 400Gbps-PAM4 x 2 = 800Gbps x 18組 = 100GB/s x 18組 = 1800GB/s (片側)

のどちらかだと思うのですが、まだ、400Gbps-PAM4 は無さそうなので、1)では?もしかしたら、独自に開発していて、2026年のRubinに間に合うかもしれません。

I/O Die には、他にも

- DMA Engine

が載るはずです。そして、このDMA Engine は I/O Die と直接繋がっている Compute DIe だけでなく、真ん中のCompute DieのHBM4とのデータ移動を行うことになります。そうなると、Compute Engine の真ん中にはデータ移動のための通路が必要になります。

おわりに

Rubin は、Compute DIe + I/O Die + HBM4 の構成です。

これは、Intel の Granite Rapids と同じ構成ですね。Granite Rapidsでは、メモリはHBM4ではなく、DDR5系ですが。